Duplicate content is een SEO term en zegt dat dezelfde content op meerdere plaatsen op een website of op het internet voorkomt. In dit artikel bespreken we :

- Wat is duplicate content precies?

- Welke soorten zijn er?

- Oorzaken?

- Hoe het te ontdekken?

- Hoe gaat Google om met duplicate content?

- Gevolgen voor SEO

- Tenslotte, hoe duplicate content oplossen?

1. Wat is duplicate content ?

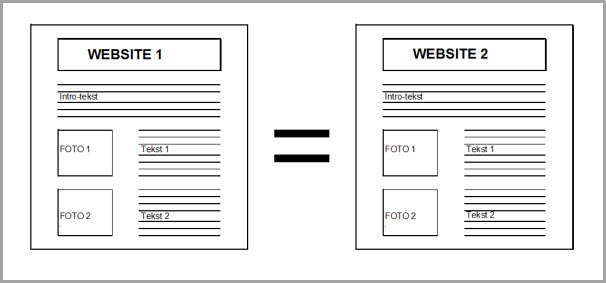

Duplicate content, of “dubbele inhoud” in het Nederlands, wil zeggen dat er 2 of meerdere webpagina’s identiek of quasi identiek zijn qua inhoud op 1 bepaalde website of op verschillende sites. Onderstaande figuur maakt dit visueel duidelijk.

2. Soorten

Echte-duplicate-content

Dit zijn webpagina’s die 100% gelijk zijn qua content aan een andere pagina. Visueel ziet dit er zo uit :

Bijna-duplicate-content

Dit zijn webpagina’s die slechts voor een klein gedeelte verschillen van een andere pagina. Visueel ziet dit er zo uit :

Google zelf spreekt van substantiële blokken die aanzienlijk op elkaar lijken, maar laat in het midden wat ‘substantieel’ is.

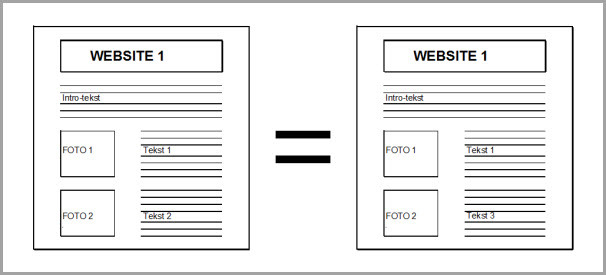

Externe-duplicate-content

Dit zijn webpagina’s die quasi of 100% gelijk zijn aan de content van andere websites. In de meeste gevallen ziet Google welke site de oorspronkelijke webpagina heeft gepubliceerd, en zal het de andere site bestraffen. Visueel geeft dat volgende beeld:

3. Oorzaken van duplicate content?

Veelal ontstaat dubbele content gewoon … per ongeluk en zijn niet misleidend bedoeld. De volgende voorbeelden maken dat duidelijk.

www versus non-www

- waarschijnlijk de grootste veroorzaker van duplicate pages

- zowel de www als de non-www pagina’s worden in dit geval geïndexeerd

- voorbeeld:

- https://www.website.be

- https://website.be

Trailing /

- technisch gezien is een URL met trailing / een andere dan een URL zonder de /

- voorbeeld:

- https://www.website.be/schoenen

- https://www.website.be/schoenen/

- was vroeger een groter issue dan tegenwoordig, omdat de meeste zoekmachines nu zelf de / toevoegen en beide URL’s als dezelfde beschouwen

Https

- de huidige standaard is dat een website https is

- de kans is aanwezig dat per ongeluk zowel de https als de http pagina’s worden geïndexeerd

- voorbeeld:

- http://www.website.be

- https://www.website.be

Test-website

- de duplicate content ontstaat zodra een nieuwe website ‘onder constructie’ wordt ontwikkeld

- meestal gebeurd dat onder een nieuwe URL, zoals bijvoorbeeld https://onderconstructie.website.be

- maar het gebeurt frequent dat de ontwikkelaars na de live-gang vergeten de onder-constructie-site te blokkeren voor de crawlers

- gevolg: de pagina’s van zowel de onder-constructie-site als de vernieuwde site worden geïndexeerd

- voorbeeld:

- http://www.website.be

- http://onderconstructie.website.be

Interne zoekresultaten

- ontstaat door de interne zoekopdrachten, die bezoekers op een website invoeren

- deze zoek-pagina’s hebben geen unieke content, maar enkel snippets van andere URL’s

- voorbeeld:

- https://www.website.be/zoekresultaten?=babolat+pure+strike+tennisracket

- https://www.website.be/zoekresultaten?categorie=schoenen?page=2

- hoewel het resultaat wel verschilt per URL, wordt het probleem veroorzaakt omdat de belangrijkste meta’s van de pagina’s (zoals title tag, header, meta description) steeds dezelfde zijn.

Parameters en filters

- website maken hier dezelfde content beschikbaar via verschillende URL’s door toevoeging van een sessie-ID en andere URL’s parameters

- de sessie-id wordt gebruikt om een klant op een webshop een meer persoonlijk ervaring te geven zoals inhoud van de winkelmandje of filtermogelijkheden

- Enkele voorbeelden:

- affiliate duplicates: https://www.website.be vs https://www.website.be?affiliate=12345

- sessie-id’s : https://www.website.be vs https://www.website.be?sessie=12345

- product-duplicates: https://www.website.be/schoenen/clarkschoen1/zwart vs https://www.website.be/schoenen/clarkschoen1/bruin

- internationale duplicates: https://www.website.be/schoenen vs https://www.website.nl/schoenen

Product varianten

- komt vaak voor op webshops

- duplicate content ontstaat dat veel productitems enkel maar verschillen van elkaar qua kleur bijvoorbeeld

- Voorbeeld:

- website met 4 items: een witte, rode, blauwe en groene polo

- er zijn dus 4 URL’s

- alle info op de 4 URL’s is quasi dezelfde behalve waarschijnlijk de foto

- voor de zoekmachine zijn die 4 URL’s quasi identiek aan elkaar

Gekopieerde content

- is content dat bewust gekopieerd is van andere websites, al dan niet met toestemming van de eigenaar van de content

- indien met toestemming: weet dat dezelfde content ook elders in 1 of meerdere versies op het internet beschikbaar is, dat jouw gekopieerde content vaak de zoekresultaten niet haalt en dat je hoort terug te linken naar de oorspronkelijke bron

- indien zonder toestemming: doe dit niet, het is niet wettelijk. Bovendien loop je het risico dat Google je volledige website uit de zoekresultaten verwijderd als uit onderzoek blijkt dat er sprake is van misleidende praktijken.

4. Diagnose tools

Met de onderstaande tools kan je duplicate content ontdekken op een site.

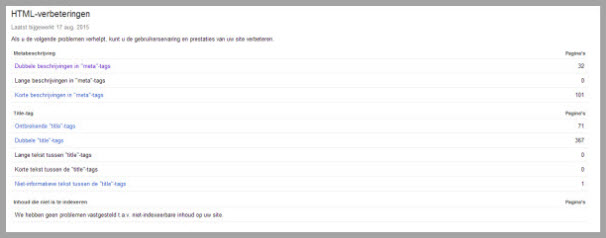

Google Search Console

Ga naar de rubriek ‘Zoekopmaak’ van je Google-webmaster-tools en klik op ‘HTML-verbeteringen’: zie onderstaande figuur.

Klik op ‘Dubbele beschrijvingen in meta-tags’ en ‘Dubbele title tags’ om vast te stellen waar je dubbele teksten hebt.

Site:

Een andere praktische tool is Google’s site: command. Wil je achterhalen of bijvoorbeeld een bepaalde landingspagina duplicaten bevat, dan kan je onderstaande opdracht in de zoekbar zetten:

![]()

Online tools

Online tools als Plag Spotter en Copyscape zijn eveneens handig om dubbele teksten op te sporen.

5. Hoe gaat Google om met duplicate content?

Google wilt haar gebruikers een kwaliteitsvolle SERP laten zien om de gebruikers een optimale zoekervaring te bieden. Om dit te behalen, filtert de zoekmachine duplicate content uit de zoekresultaten. Google’s algoritmen zijn ontworpen om duplicate content automatisch te detecteren en te bepalen welke versie de meest relevante is voor een specifieke zoekopdracht.

Onze praktijkervaring toont aan dat het bovenstaande niet altijd opgaat. We merken regelmatig dat de originele content die eerst op website A wordt geplaatst en vervolgens door website B deze grotendeels wordt gekopieerd, dat B vervolgens zelfs hoger in de zoekresultaten komt te staan dan A. Dit is uiteraard zeer frustrerend voor website A. De reden ? Waarschijnlijk betere EEAT en website-authoriteit. van B.

6. Gevolgen voor SEO

Duplicate content kan SEO problemen veroorzaken. Voor Google heeft slechts de originele webpagina waarde; de kopieën ervan generen geen toegevoegde waarde. Die dubbele pagina’s vervuilen dus de Google-index. Vóór de Google Panda update was de algemene opvatting dat duplicated content alleen maar de betreffende pagina’s kon benadelen en eigenlijk niet echt een SEO probleem was. Na de oplevering van Panda kan dubbele inhoud een gehele website treffen, dus ook non-duplicated-content. Het is dus niet langer een alleenstaand probleem.

Minder online verkeer

Google probeert diverse en relevante resultaten te bieden aan gebruikers. Als er veel duplicate content is, kan het moeilijk zijn voor zoekmachines om te bepalen welke pagina de originele versie is of het meest relevant. Dit kan resulteren in lagere posities in de zoekresultaten. Google kan er zelfs voor kiezen om webpagina’s met duplicate content te weigeren in de SERP door ze niet te indexeren.

Crawlbudget

Search engines hebben een beperkt crawlbudget om de inhoud van een website te indexeren. Als dit budget wordt verspild aan het crawlen van duplicate content, kan het zijn dat belangrijke pagina’s minder vaak worden gecrawld. En dit wil je vermijden. Voor kleine websites is dit niet echt een probleem, maar als je een zeer uitgebreide site hebt, wordt het crawl-budget wel belangrijk.

Google toont de verkeerde versie

Als je meerdere pagina’s hebt met gelijkaardige content op je website, moet Google kiezen welke pagina er getoond zal worden in de zoekresultaten. Er bestaat dus de kans dat Google de webpagina toont die jij liever niet in de SERP ziet.

Crawlbudget

Search engines hebben een beperkt crawlbudget om de inhoud van een website te indexeren. Als dit budget wordt verspild aan het crawlen van duplicate content, kan het zijn dat belangrijke pagina’s minder vaak worden gecrawld. En dit wil je vermijden. Voor kleine websites is dit niet echt een probleem, maar als je een zeer uitgebreide site hebt, wordt het crawl-budget wel belangrijk.

Vermindering van linkwaarde

Als dezelfde content op meerdere pagina’s wordt weergegeven, kan de linkwaarde die naar die content wordt opgebouwd door linkbuilding, worden verdeeld over de verschillende URL’s. Dit betekent dat de individuele pagina’s mogelijk minder linkwaarde ontvangen dan wanneer alle links naar één enkele versie zouden wijzen.

Een Google penalty

Geen paniek, de kans dat je een penalty van Google zal krijgen voor duplicate content is zeer laag. Enkel als je enorm veel duplicate content hebt op je site met het doel de zoekresultaten te spammen en te beïnvloeden, kan je een penalty krijgen met mogelijke de-indexatie tot gevolg

7. Oplossingen

Ok, nu we weten wat duplicate content is, hoe we het kunnen ontdekken en wat de gevolgen zijn, willen we uiteraard het ook oplossen. Dat kan met de volgende technieken.

Redirect 301

- Via de 301-redirect kunnen pagina’s, zowel voor bezoekers als crawlers, permanent verplaatst worden naar een andere locatie.

- Dus als een bezoeker op URL1 (de oude of slechte pagina) komt, wordt hij via de 301 doorverwezen (redirected) naar de nieuwe, betere URL2.

Verwijderen 404

De meest eenvoudige oplossing is de gedupliceerde content verwijderen en een 404 error pagina terugsturen. Indien de content echt geen waarde heeft qua zoekverkeer en links, dan is dit een correcte oplossing.

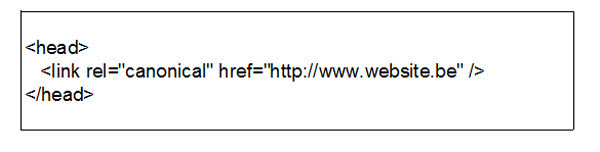

Canonical tag

Indien unieke content toegankelijk is via meerdere URL’s, dan dient de voorkeurs-URL aan de search engine bekend gemaakt te worden. Dit kan door gebruik te maken van de zogenaamde canonical tag (wanneer beide URL’s operationeel moeten blijven), zie voorbeeld hieronder. Hiermee zeg je aan Google dat het de linkwaarde aan de originele, beste pagina dient toe te kennen.

Robots.txt

Een andere optie is de gedupliceerde pagina’s toegankelijk te laten voor online bezoekers, maar te blokkeren voor de crawl-spiders via de robots.txt file.

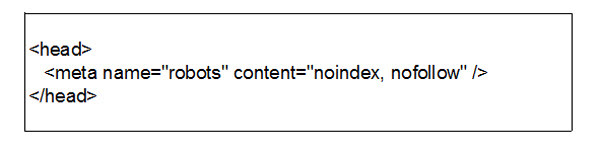

Meta robots tag

- Een betere SEO oplossing dan 6.5. is aan de zoekmachines te zeggen dat ze een bepaalde webpage niet mogen crawlen & indexeren. Dat kan via onderstaande tag:

- Via de meta robots tag willen we dus URLs, die reeds in de index zitten, uit die index verwijderen

- De code zegt dus aan zoekmachines “hallo daar, gelieve deze URL niet langer te indexeren”.

URL-parameters Search Console

- Je kan URL parameters managen via “URL-parameters” in (de oude sectie van) Google Search Console

- daar kan je aan Google zeggen hoe het met bepaalde parameters moet omgaan.

Unieke content

Search engines hebben niet liever dat websites unieke, relevante content bieden aan hun online bezoekers. De simpelste manier om dubbele content te voorkomen is dus om zelf onderscheidende content te schrijven. Ontdek je gedupliceerde teksten op je website, dan is de boodschap herschrijven.

Samenvattend

Duplicate content ontstaat in de meeste gevallen onbewust en kan een negatieve invloed hebben op de SEO-posities van een website. Maak gebruik van de diagnose tools én oplossingen in dit artikel en ban dubbele inhoud van je site.

Wil jij de SEO-problemen van jouw website te weten komen?